Un robot androide fa il dito medio (Shutterstock).

Come dovranno essere i robot del futuro? Realistici, ma non troppo. Potranno criticarci ma è meglio che non ci insultino, anche quando sbagliamo. Altrimenti rischiano di peggiorare le nostre prestazioni. L’ha accertato un originale esperimento svolto da poco alla Carnegie Mellon University di Pittsburgh, negli Usa. Gli scienziati hanno reclutato 39 persone e le hanno fatte competere in un gioco di strategia contro un robot. Nel frattempo, l’automa giudicava le loro prestazioni con frasi di incoraggiamento o di disprezzo. Risultato: i giocatori che erano stati insultati hanno ottenuto prestazioni inferiori rispetto a quelli elogiati. Anche se sapevano benissimo che la disistima non era espressa da una persona in carne e ossa, bensì da un cervello elettronico appositamente programmato.

L’esperimento è doppiamente interessante: ci fa capire che i nostri avatar elettronici dovranno essere migliori di noi, almeno dal punto di vista del linguaggio. E rivela quanto sia radicata in noi la ricerca di consenso da parte di altri, fossero anche dei “surrogati umani” come i robot.

Se ci somigliano, proviamo affetto

Ma prima di riflettere sulle sue ricadute, meglio raccontare questo studio, intitolato “A robot’s expressive language affects human strategy and perceptions in a competitive game” (il linguaggio espressivo di un robot influenza la strategia e le percezioni in un gioco competitivo), presentato alla 28° Conferenza internazionale dell’Institute of Electrical and Electronic Engineers sulla comunicazione interattiva fra robot e umani svolta in ottobre a Nuova Delhi in India.

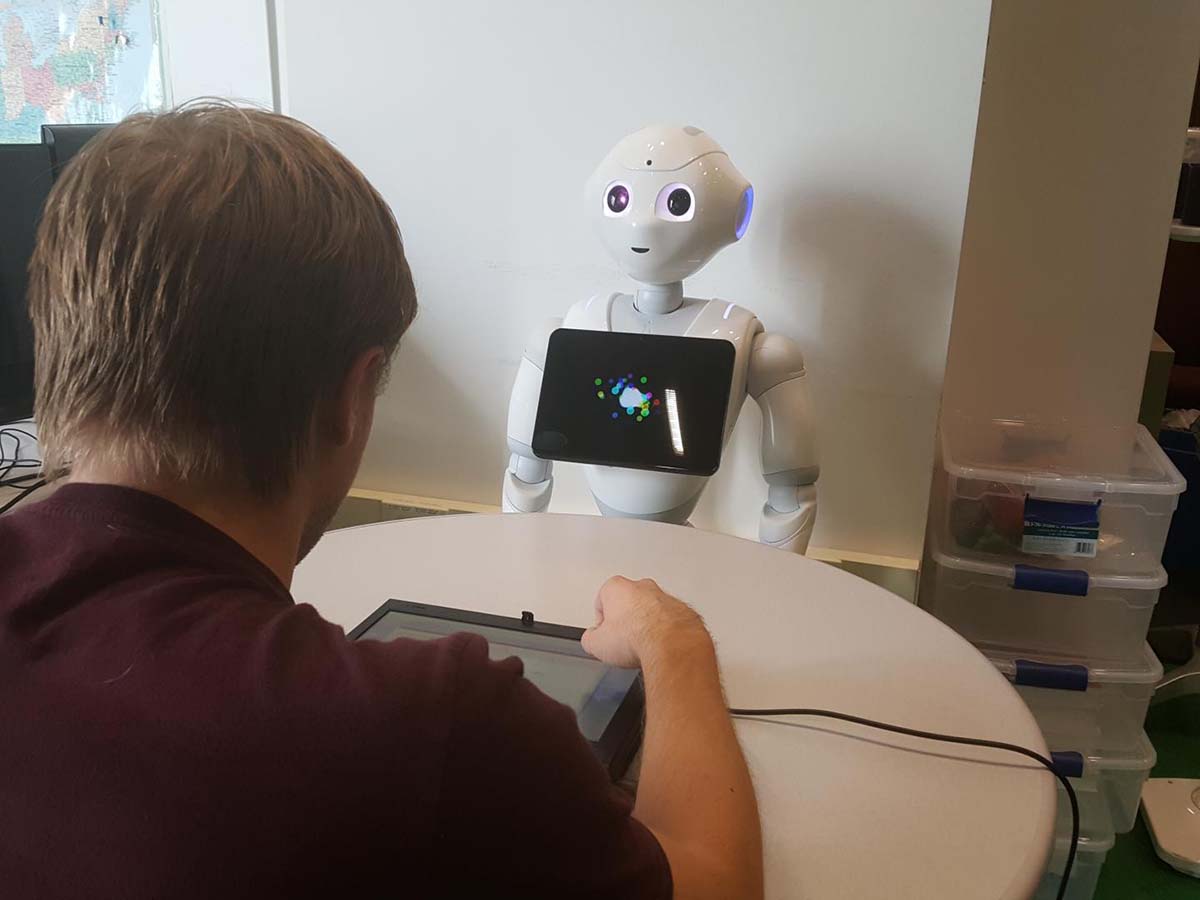

Un giocatore durante la sfida col robot Pepper.

Gli scienziati, guidati da Aaron Roth, informatico dell’Università della Pennsylvania, hanno deciso di fare questo studio perché la letteratura sulle interazioni fra uomo e macchine, pur essendo molto nutrita, finora si è concentrata solo su situazioni di collaborazione fra uomini e robot: per esempio nel campo della riabilitazione, della compagnia o dell’istruzione.

Una collaborazione che diventa più efficace se il robot è umanoide, ovvero ha un aspetto umano (viso, braccia, gambe) ed è in grado di parlare. Diverse ricerche hanno evidenziato che l’aspetto antropomorfo del robot induce sentimenti di empatia, voglia di interagire, perfino affetto: lo stesso affetto che si riversa su un animale domestico, cane o gatto che sia. Almeno, finché le sembianze umane del robot non diventino perfette: in tal caso, le persone entrano in uno stato di disagio chiamato “uncanny valley”. Una macchina che ci somiglia ci fa sentire a nostro agio. Ma quando la somiglianza è eccessiva genera inquietudine e repulsione: perché a quel punto non sappiamo più quale sia il confine fra un essere umano e uno artificiale. E, in questo, possono aiutarci proprio le parolacce: un’altra ricerca (che avevo raccontato in un articolo) aveva mostrato che sono proprio le volgarità a distinguere un uomo da un robot.

L’esperimento: una sfida di strategia

Ma cosa avviene quando fra uomo e robot c’è competizione? Per verificarlo, gli scienziati hanno reclutato 39 persone (24 donne, 15 uomini, età media 27 anni) e li hanno messi di fronte a un robot della Softbanks, il celebre Pepper: un automa umanoide con una testa dotata di microfono e video camera, capace di parlare e muovere le braccia.

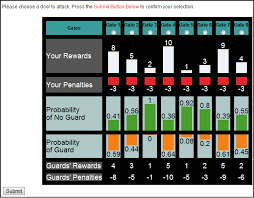

Una schermata di “Guard and treasures”.

L’obiettivo era una sfida a “Guards and treasures” (guardie e tesori), un gioco di strategia usato in diverse ricerche per valutare la razionalità dei giocatori in un’interazione tra difensore e attaccante. Il gioco è ispirato al duopolio di Stackelberg, un modello economico che prevede una sfida tra una società leader, che muove per prima, e una subalterna, che muove per seconda. In particolare, l’attaccante sceglie di aggredire un determinato cancello: se è sguarnito, vince punti; se invece è sorvegliato da una guardia, perde punti.

I partecipanti facevano prima un paio di partite da soli, per fare pratica. E poi due tornate da 35 partite ciascuna contro il robot Pepper, che era messo seduto dall’altra parte del tavolo. Nella seconda manche, il robot diceva alcuni commenti, che potevano essere di incoraggiamento o di disprezzo:

| Frasi di incoraggiamento | Frasi di disprezzo |

|

|

Chi è insultato gioca peggio

Quale effetto hanno avuto le frasi di Pepper? Chi era stato offeso ha avuto prestazioni inferiori del 12% rispetto a chi era stato elogiato. In pratica, un robot che manifesta comportamenti che imitano le nostre emozioni, influenza davvero le emozioni degli esseri umani: un risultato che conferma diverse ricerche fatte in passato. Solo che in questo esperimento le emozioni si collocavano in un contesto competitivo.

Alcuni giocatori, peraltro, erano infastiditi dai giudizi negativi non tanto per il loro contenuto, quanto per la loro stessa presenza: li consideravano, insomma, una forma di disturbo che minava la loro concentrazione. I partecipanti più giovani erano meno influenzati dalle frasi del robot, perché erano più consapevoli di avere a che fare con macchine.

Anche l’intelligenza artificiale può emozionarci (Shutterstock).

Quali conclusioni trarre da questa ricerca? Il campione di volontari era troppo piccolo per trarre conclusioni universali e definitive. Tuttavia, il test è interessante perché mostra quanto siamo sensibili ai giudizi altrui: se sono complimenti, ci sostengono e ci aiutano a vincere; se sono offese ci deprimono, e rendiamo meno. Persino quando ci arrivano da una macchina.

In altre parole, la ricerca conferma che l’uomo è un animale sociale: cerca nel rapporto con gli altri non solo stimoli, aiuto, scambi, ma anche (e soprattutto) stima. Le altre persone sono lo specchio delle nostre capacità, confermano o smentiscono se siamo in gamba. Ecco perché ricevere un riscontro di segno contrario (disistima) ci fa particolarmente male.

In più, l’esperimento può essere interessante per chi sta progettando l’aspetto e il comportamento dei robot del futuro. Se vorranno rispettare la prima legge dei robot formulata da Isaac Asimov (“Un robot non può recar danno a un essere umano”), è meglio che non ci insultino. Anche se sappiamo che gli automi sono un ammasso di chip, proviamo affetto e stima per loro: l’intelligenza artificiale è per molti aspetti superiore alla nostra. Quindi, essere insultati da loro non ci lascia indifferenti: mina la nostra autostima. E se invece dicessero parolacce per farci ridere? Su questo bisogna attendere: i chip non sono capaci di humor volgare. Almeno per ora.

Grazie Vito, hai pubblicato un articolo davvero interessante che aiuta a riflettere sulle interazioni tra l’uomo ed il mondo che lo circonda. Abbiamo ego che necessitano continuamente di essere nutriti con l’approvazione e ora sappiamo che basta anche una approvazione surrogata. Incredibile!

Mi chiedo: è il fatto che umanizziamo tutto a renderci sensibili agli insulti

di un robot oppure questo avviene xchè sappiamo che dietro c’è stato un umano ad

“addestrarlo”, quindi c’è una sorta di causa-effetto programmata?

Un pappagallo che ci insulta solo xchè ha sentito le parolacce tutto il giorno ma non ne conosce

l’intenzione è offensivo?

E un bambino piccolo che dice (ripete) senza saper, quindi senza intenzione/emozione?